Después de anunciarlo en los medios de comunicación, OpenAI ha lanzado una herramienta que intenta distinguir entre texto escrito por humanos y texto generado por IA, como el producido por los modelos ChatGPT y GPT-3 de la propia empresa. El clasificador no es especialmente preciso -su porcentaje de acierto es de alrededor del 26%, señala OpenAI-, pero OpenAI argumenta que, cuando se utiliza junto con otros métodos, podría ser útil para ayudar a evitar que se abuse de los generadores de texto de IA.

«El clasificador pretende ayudar a mitigar las falsas afirmaciones de que el texto generado por IA fue escrito por un humano. Sin embargo, todavía tiene una serie de limitaciones – por lo que debe ser utilizado como un complemento a otros métodos para determinar el origen del texto en lugar de ser la principal herramienta de toma de decisiones», dijo un portavoz de OpenAI a través de correo electrónico. «Estamos haciendo este clasificador inicial disponible para obtener retroalimentación sobre si las herramientas como esta son útiles, y esperamos compartir métodos mejorados en el futuro».

A medida que crece el fervor en torno a la IA generativa -particularmente la IA generadora de texto-, los críticos han pedido a los creadores de estas herramientas que tomen medidas para mitigar sus efectos potencialmente dañinos. Algunos de los mayores distritos escolares de Estados Unidos han prohibido ChatGPT en sus redes y dispositivos, por temor a las repercusiones en el aprendizaje de los alumnos y la precisión del contenido que produce la herramienta. Y sitios como Stack Overflow han prohibido a los usuarios compartir contenidos generados por ChatGPT, alegando que la IA hace que sea demasiado fácil para los usuarios inundar los hilos de discusión con respuestas dudosas.

El clasificador de OpenAI -llamado acertadamente OpenAI AI Text Classifier- es intrigante desde el punto de vista arquitectónico. Al igual que ChatGPT, se trata de un modelo lingüístico de IA entrenado a partir de muchísimos ejemplos de texto disponibles públicamente en la web. Pero, a diferencia de ChatGPT, está afinado para predecir la probabilidad de que un texto haya sido generado por IA, no sólo por ChatGPT, sino por cualquier modelo de IA que genere texto.

Más concretamente, OpenAI entrenó el clasificador de texto de IA de OpenAI con texto de 34 sistemas de generación de texto de cinco organizaciones diferentes, incluida la propia OpenAI. Este texto se emparejó con texto similar (pero no exactamente similar) escrito por humanos de Wikipedia, sitios web extraídos de enlaces compartidos en Reddit y un conjunto de «demostraciones humanas» recopiladas para un sistema anterior de generación de texto de OpenAI. (OpenAI admite en un documento de apoyo, sin embargo, que podría haber clasificado inadvertidamente algunos textos escritos por IA como escritos por humanos «dada la proliferación de contenidos generados por IA en Internet»).

El clasificador de textos de OpenAI no funciona con cualquier texto. Necesita un mínimo de 1.000 caracteres, es decir, entre 150 y 250 palabras. No detecta el plagio, una limitación especialmente desafortunada si se tiene en cuenta que se ha demostrado que la IA generadora de textos regurgita el texto con el que se ha entrenado. Además, OpenAI afirma que es más probable que se equivoque con textos escritos por niños o en un idioma distinto del inglés, debido a su conjunto de datos en inglés.

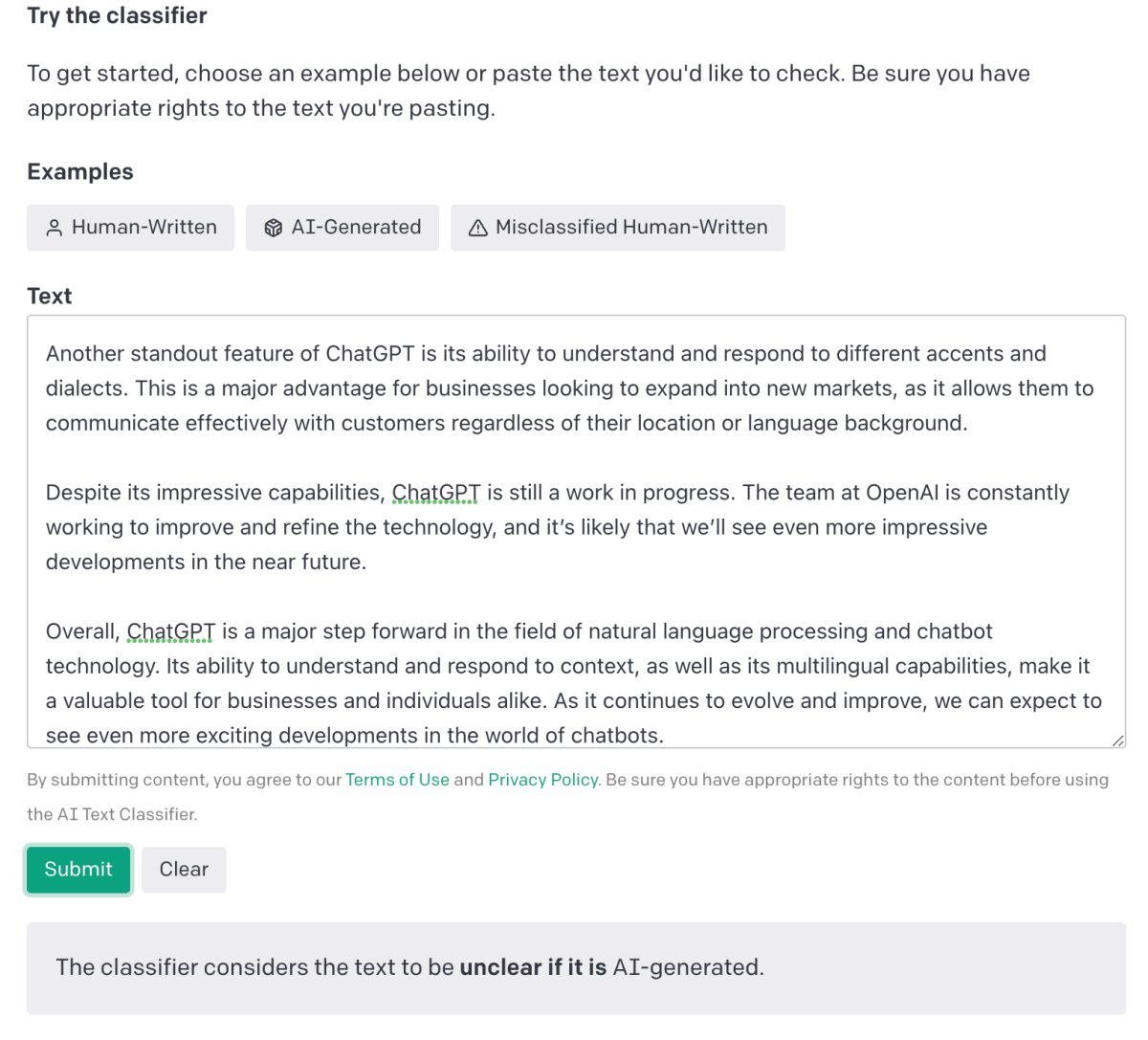

A la hora de evaluar si un texto ha sido generado por inteligencia artificial, el detector se muestra un poco cauteloso. En función de su nivel de confianza, clasifica el texto como «muy improbable» (menos del 10%), «improbable» (entre el 10% y el 45%), «no está claro» (entre el 45% y el 90%), «posiblemente» (entre el 90% y el 98%) o «probablemente» (más del 98%).

Por curiosidad, he introducido un texto en el clasificador para ver cómo se las apañaba. Si bien predijo correctamente y con confianza que varios párrafos de un artículo de TechCrunch sobre Horizon Worlds de Meta y un fragmento de una página de soporte de OpenAI no habían sido generados por IA, el clasificador tuvo más dificultades con el texto de un artículo de ChatGPT y finalmente no logró clasificarlo. Sin embargo, sí detectó con éxito la salida de ChatGPT de un artículo de Gizmodo sobre… ¿qué más? – ChatGPT.

Según OpenAI, el clasificador etiqueta incorrectamente texto escrito por humanos como escrito por IA el 9% de las veces. Este error no se produjo en mis pruebas, pero lo achaco al pequeño tamaño de la muestra.

En la práctica, el clasificador no me ha resultado especialmente útil para evaluar escritos breves. De hecho, 1.000 caracteres es un umbral difícil de alcanzar en el ámbito de los mensajes, por ejemplo los correos electrónicos (al menos los que yo recibo habitualmente). Y las limitaciones dan que pensar: OpenAI subraya que el clasificador puede eludirse modificando algunas palabras o cláusulas del texto generado.

Esto no quiere decir que el clasificador sea inútil, ni mucho menos. Pero, en su estado actual, no detendrá a los defraudadores (ni a los estudiantes).

La pregunta es: ¿lo harán otras herramientas? Ha surgido una especie de industria artesanal para satisfacer la demanda de detectores de texto generados por IA. ChatZero, desarrollado por un estudiante de la Universidad de Princeton, utiliza criterios como la «perplejidad» (la complejidad del texto) y la «explosividad» (las variaciones de las frases) para detectar si un texto puede estar escrito con IA. Turnitin, detector de plagios, está desarrollando su propio detector de textos generados por inteligencia artificial. Además de éstas, una búsqueda en Google arroja al menos media docena de otras aplicaciones que afirman ser capaces de separar el trigo generado por IA de la paja generada por humanos, para torturar la metáfora.

Es probable que se convierta en un juego del gato y el ratón. A medida que mejore la IA generadora de texto, también lo harán los detectores: un interminable tira y afloja similar al que existe entre los ciberdelincuentes y los investigadores de seguridad. Y como escribe OpenAI, aunque los clasificadores pueden ayudar en determinadas circunstancias, nunca serán una prueba única fiable para decidir si el texto ha sido generado por IA.

Todo esto viene a decir que no existe una solución milagrosa para resolver los problemas que plantea el texto generado por IA. Lo más probable es que nunca la haya.