La guía completa de robots.txt para WordPress

En el competitivo mundo de la optimización de motores de búsqueda, cada detalle cuenta para garantizar que tu sitio web alcance las primeras posiciones en las páginas de resultados de motores de búsqueda (SERP). Una herramienta esencial para lograr esto es el archivo robots.txt, y en esta guía completa de robots.txt para WordPress, te mostraremos cómo aprovechar al máximo esta poderosa herramienta.

En el competitivo mundo de la optimización de motores de búsqueda, cada detalle cuenta para garantizar que tu sitio web alcance las primeras posiciones en las páginas de resultados de motores de búsqueda (SERP). Una herramienta esencial para lograr esto es el archivo robots.txt, y en esta guía completa de robots.txt para WordPress, te mostraremos cómo aprovechar al máximo esta poderosa herramienta.

Table of Contents

Toggle¿Qué es un archivo robots.txt y por qué es importante?

Un archivo robots.txt es un archivo de texto que le proporciona instrucciones a los robots de los motores de búsqueda sobre qué partes de tu sitio web pueden rastrear y qué partes deben evitar. Esto es esencial para garantizar que los motores de búsqueda indexen las páginas que realmente importan y eviten perder tiempo en contenido irrelevante o confidencial.

Cuando los motores de búsqueda como Google envían sus arañas (o robots rastreadores) a explorar tu sitio web, necesitan pautas claras para saber qué deben y no deben indexar. Sin un archivo robots.txt, estarías dejando que los robots rastreen todo tu contenido, incluso áreas que deberían permanecer ocultas.

Cuando los motores de búsqueda como Google envían sus arañas (o robots rastreadores) a explorar tu sitio web, necesitan pautas claras para saber qué deben y no deben indexar. Sin un archivo robots.txt, estarías dejando que los robots rastreen todo tu contenido, incluso áreas que deberían permanecer ocultas.

Además, sin un archivo robots.txt, podrías tener una invasión de robots en tu sitio web, lo que podría afectar negativamente su rendimiento y velocidad de carga. Los usuarios no quieren esperar eternamente para que un sitio se cargue, y esto puede tener un impacto directo en tu tasa de rebote y posicionamiento en los motores de búsqueda.

¿Dónde se encuentra el archivo robots.txt en WordPress?

Cuando creas un sitio web en WordPress, se genera automáticamente un archivo robots.txt virtual en la carpeta principal de tu servidor. Puedes acceder a él visitando la dirección tusitioweb.com/robots.txt, donde «tusitioweb.com» es la URL de tu sitio web.

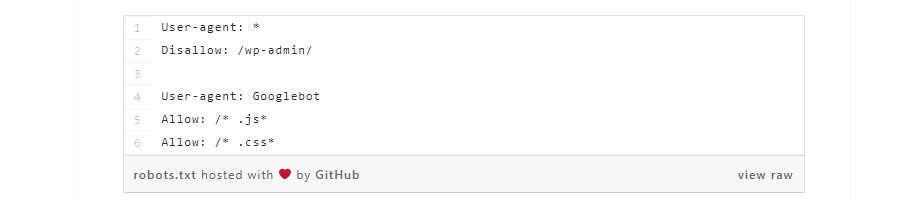

Un ejemplo de un archivo robots.txt básico generado por WordPress se ve así:

Un ejemplo de un archivo robots.txt básico generado por WordPress se ve así:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Este archivo está diseñado para decirle a los motores de búsqueda que no deben acceder a los directorios wp-admin y wp-includes, que contienen información confidencial de tu sitio.

Sin embargo, este archivo predeterminado no es accesible ni editable desde ningún directorio. Si deseas realizar cambios en él o personalizarlo, deberás crear tu propio archivo robots.txt y cargarlo en la carpeta raíz de tu sitio web.

¿Qué reglas incluir en el archivo robots.txt de WordPress?

La configuración de tu archivo robots.txt depende de tus necesidades específicas. Aquí hay algunos ejemplos de reglas comunes que puedes incluir:

- Disallow: Indica qué archivos o directorios no deben rastrearse. Por ejemplo, puedes usar

Disallow: /wp-admin/para evitar que los motores de búsqueda accedan a tu panel de administración. - Allow: Permite que los motores de búsqueda rastreen un directorio o archivo específico incluso si se ha establecido una regla de «Disallow». Por ejemplo, puedes usar

Allow: /wp-content/uploads/para permitir que se indexen las imágenes en tu directorio de subidas. - Crawl-delay: Puedes especificar la velocidad a la que los robots deben rastrear tu sitio web. Esto puede ayudar a evitar una carga excesiva en tu servidor. Por ejemplo,

Crawl-delay: 10significa que se debe esperar al menos 10 segundos entre cada solicitud de rastreo. - Noindex: Esta directiva es específica de Google y le indica que no debe indexar una página o archivo en particular. Por ejemplo,

Noindex: /pagina-secreta/asegura que Google no muestre esa página en los resultados de búsqueda. - User-agent: Puedes especificar las reglas para un agente de usuario específico (robot de búsqueda). Por ejemplo,

User-agent: Bingbotseguido de reglas te permite personalizar la interacción con el robot de búsqueda de Bing.

También puedes usar comodines como * para aplicar reglas a todos los bots y $ para especificar caracteres que no deben indexarse en documentos o archivos.

¿Cómo crear un archivo robots.txt en WordPress?

Existen tres métodos principales para crear y editar un archivo robots.txt en WordPress:

- Usar un Plugin: WordPress ofrece varios plugins que facilitan la creación y edición del archivo robots.txt. Ejemplos populares incluyen «Yoast SEO» y «All in One SEO Pack». Estos plugins te permiten personalizar tu archivo robots.txt desde el panel de administración de WordPress.

- Edición Manual: Puedes crear y editar el archivo robots.txt directamente en tu servidor utilizando un cliente FTP o el administrador de archivos de tu hosting. Asegúrate de cargar el archivo en la raíz de tu sitio web.

- Herramientas en línea: También puedes utilizar herramientas en línea para generar un archivo robots.txt personalizado. Luego, descarga el archivo y cárgalo en la raíz de tu sitio web.

En resumen, la configuración de un archivo robots.txt adecuado en WordPress es esencial para guiar a los motores de búsqueda y optimizar tu posicionamiento en SERP. Aprovecha esta guía completa para asegurarte de que los robots de búsqueda trabajen a tu favor y ayuden a que tu sitio web se destaque en línea. Con un archivo robots.txt bien configurado, estarás un paso más cerca de alcanzar tus objetivos de optimización de motores de búsqueda.

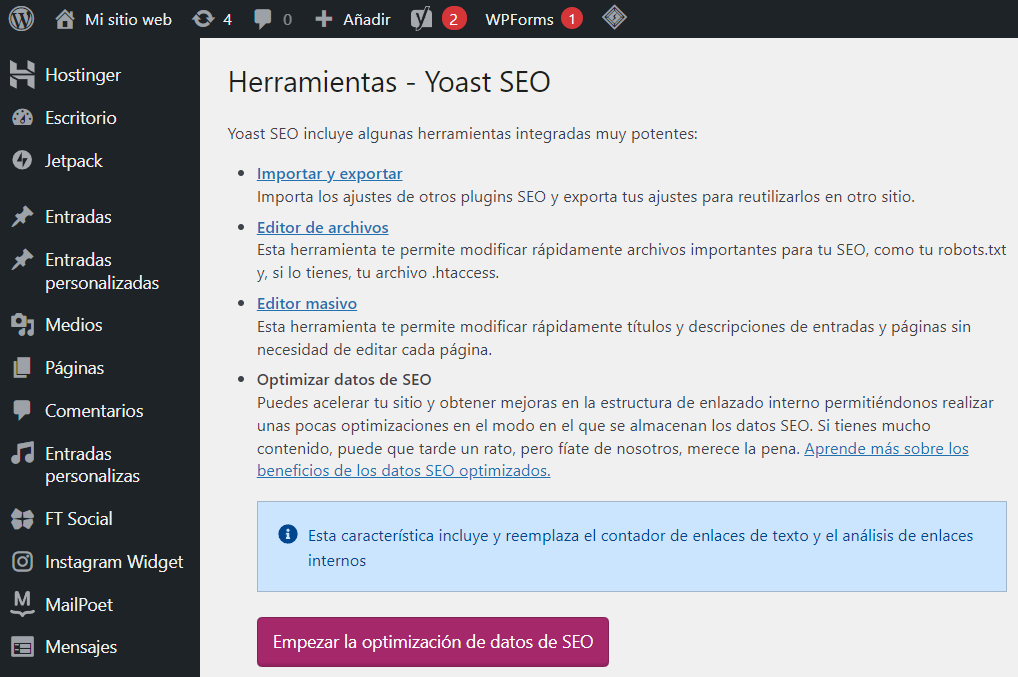

Plugin Yoast SEO para WordPress

Uno de los métodos más sencillos para crear y editar tu archivo robots.txt en WordPress es utilizando el popular plugin Yoast SEO. Este plugin no solo te permite optimizar tus publicaciones y páginas para palabras clave, sino que también facilita la creación y gestión del archivo robots.txt. Aquí te mostramos cómo hacerlo:

Uno de los métodos más sencillos para crear y editar tu archivo robots.txt en WordPress es utilizando el popular plugin Yoast SEO. Este plugin no solo te permite optimizar tus publicaciones y páginas para palabras clave, sino que también facilita la creación y gestión del archivo robots.txt. Aquí te mostramos cómo hacerlo:

- Instala el Plugin Yoast SEO: Si aún no tienes instalado el plugin Yoast SEO en tu sitio de WordPress, puedes hacerlo desde el panel de administración de WordPress. Ve a «Plugins» y luego «Agregar nuevo». Busca «Yoast SEO» y haz clic en «Instalar ahora» y luego en «Activar».

- Accede al Editor de Archivos: Una vez que hayas activado el plugin Yoast SEO, dirígete a la pestaña «SEO» en el menú de tu escritorio de WordPress y selecciona «Herramientas». Luego, busca la opción que dice «Editor de archivos».

- Crear el Archivo robots.txt: Al hacer clic en «Editor de archivos», serás dirigido a una nueva página que te permite editar tu archivo robots.txt sin salir del escritorio de WordPress. Además, encontrarás un botón útil con la etiqueta «Crear archivo robots.txt». Este botón te permitirá crear un archivo robots.txt personalizado.

- Edición del Archivo robots.txt: Una vez que hagas clic en el botón «Crear archivo robots.txt», aparecerá un nuevo editor en la página. Aquí podrás modificar tu archivo robots.txt directamente. Ten en cuenta que Yoast SEO establece sus propias reglas predeterminadas, que anulan tu archivo robots.txt virtual existente.

- Guardar Cambios: Cada vez que agregues, elimines o modifiques reglas en tu archivo robots.txt, asegúrate de hacer clic en el botón «Guardar cambios en robots.txt» para que los cambios surtan efecto.

El proceso es muy sencillo y te permite personalizar tu archivo robots.txt según las necesidades específicas de tu sitio web. Sin embargo, ten en cuenta que Yoast SEO establece reglas predeterminadas que puedes personalizar según tus preferencias.

El proceso es muy sencillo y te permite personalizar tu archivo robots.txt según las necesidades específicas de tu sitio web. Sin embargo, ten en cuenta que Yoast SEO establece reglas predeterminadas que puedes personalizar según tus preferencias.

Plugin All in One SEO Pack para WordPress

Si prefieres usar el plugin «All in One SEO Pack» en lugar de Yoast SEO, también puedes crear y editar tu archivo robots.txt de manera fácil. A continuación, te mostramos cómo hacerlo:

Si prefieres usar el plugin «All in One SEO Pack» en lugar de Yoast SEO, también puedes crear y editar tu archivo robots.txt de manera fácil. A continuación, te mostramos cómo hacerlo:

- Instala el Plugin All in One SEO Pack: Si aún no tienes instalado el plugin All in One SEO Pack en tu sitio de WordPress, puedes hacerlo desde el panel de administración de WordPress. Ve a «Plugins» y luego «Agregar nuevo». Busca «All in One SEO Pack» y haz clic en «Instalar ahora» y luego en «Activar».

- Accede a la Configuración de Robots.txt: Una vez que hayas activado el plugin All in One SEO Pack, ve a la página «All in One SEO» en el menú de tu escritorio de WordPress y selecciona «Herramientas».

- Configuración del Archivo robots.txt: Aquí, encontrarás una nueva pestaña llamada «Robots.txt». Haz clic en ella y verás opciones para agregar nuevas reglas a tu archivo robots.txt.

- Agregar Reglas: Puedes agregar nuevas reglas según tus necesidades específicas. A diferencia de Yoast SEO, en este plugin no puedes editar directamente el archivo robots.txt, ya que el archivo en sí está atenuado en gris. Sin embargo, puedes agregar reglas de forma sencilla en la interfaz proporcionada.

- Guardar Cambios: Asegúrate de guardar los cambios que realices en tu archivo robots.txt usando la opción correspondiente dentro de la página de configuración del plugin.

A pesar de que no puedes editar el archivo directamente, este método sigue siendo fácil de usar y te permite personalizar tu archivo robots.txt según tus preferencias y necesidades específicas.

Creación y Carga Manual de tu Archivo robots.txt de WordPress a través de FTP

Si prefieres evitar el uso de plugins y deseas crear y cargar tu archivo robots.txt manualmente, aquí tienes los pasos a seguir:

- Creación del Archivo robots.txt Manualmente: Utiliza tu editor de texto favorito, como Notepad o TextEdit, para crear un archivo robots.txt personalizado. Escribe las reglas que deseas aplicar y guárdalo con el nombre «robots.txt».

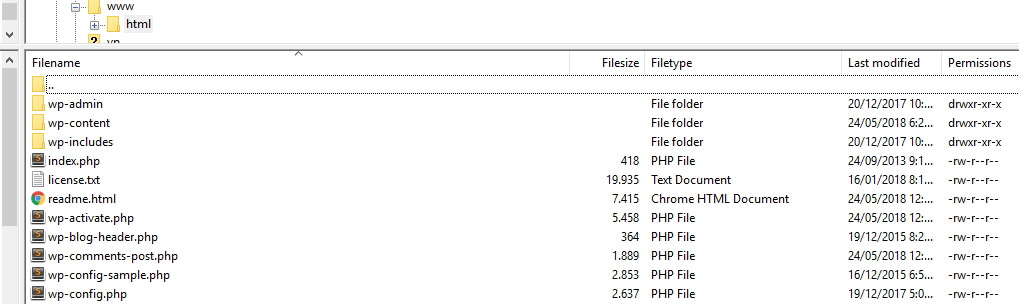

- Conexión a través de FTP: Conéctate a tu sitio web a través de FTP utilizando un cliente FTP como FileZilla. Esto te permitirá acceder a los archivos de tu sitio.

- Carga del Archivo robots.txt: Navega hasta la carpeta «public_html» en tu servidor, que generalmente es la carpeta raíz de tu sitio web. Luego, carga el archivo robots.txt que has creado en tu computadora a esta carpeta en tu servidor.

La carga del archivo debería ser rápida, y habrás configurado tu archivo robots.txt sin necesidad de utilizar un plugin.

Prueba y Verificación en Google Search Console

Una vez que hayas creado y cargado tu archivo robots.txt de WordPress, es importante verificar que funcione correctamente y no tenga errores. Puedes hacerlo utilizando Google Search Console, una herramienta proporcionada por Google para monitorear la visibilidad de tu sitio en los resultados de búsqueda.

Para probar tu archivo robots.txt:

- Inicia sesión en Google Search Console y navega a la pestaña «Rastreo».

- Selecciona la opción «Probador de robots.txt».

- En el campo de edición, agrega el contenido de tu archivo robots.txt.

- Haz clic en el botón «Enviar».

Google Search Console verificará tu archivo y te notificará si encuentra algún error. Si todo está en orden, habrás configurado correctamente tu archivo robots.txt en WordPress.

En resumen, editar y configurar un archivo robots.txt en WordPress es esencial para guiar a los motores de búsqueda y optimizar tu presencia en línea. Tanto Yoast SEO como All in One SEO Pack facilitan este proceso, pero también puedes optar por crear y cargar el archivo manualmente a través de FTP. Asegúrate de verificar y probar tu archivo en Google Search Console para garantizar un funcionamiento correcto.

Preguntas frecuentes sobre el archivo robots.txt

¿Por qué es importante tener un archivo robots.txt en WordPress?

El archivo robots.txt es importante porque permite controlar qué partes de tu sitio web son accesibles para los motores de búsqueda, lo que afecta directamente al posicionamiento en los resultados de búsqueda.

¿Qué sucede si no tengo un archivo robots.txt en mi sitio de WordPress?

Si no tienes un archivo robots.txt, los motores de búsqueda rastrearán y indexarán todo el contenido de tu sitio web, incluyendo áreas que pueden contener información confidencial o irrelevante para los resultados de búsqueda.

¿Puedo permitir que ciertos motores de búsqueda accedan a mi sitio mientras bloqueo a otros?

Sí, puedes especificar reglas diferentes para motores de búsqueda específicos en tu archivo robots.txt. Esto te permite permitir el acceso a algunos motores de búsqueda mientras bloqueas a otros.

¿Qué sucede si modifico el archivo robots.txt incorrectamente?

Si realizas cambios incorrectos en tu archivo robots.txt, podrías bloquear el acceso de los motores de búsqueda a partes importantes de tu sitio web, lo que podría afectar negativamente tu posicionamiento en los resultados de búsqueda. Es importante verificar y probar tu archivo después de hacer cambios.

¿Cómo puedo verificar si mi archivo robots.txt funciona correctamente?

Puedes usar la herramienta «Probador de robots.txt» en Google Search Console para verificar si tu archivo robots.txt está configurado correctamente y no contiene errores.

¿Puedo usar comodines en el archivo robots.txt?

Sí, puedes utilizar comodines como ‘*’ para indicar que una directiva se aplica a todos los motores de búsqueda, o ‘$’ para bloquear archivos o directorios con caracteres específicos en el nombre.

¿Cuál es la diferencia entre «Disallow» y «Allow» en el archivo robots.txt?

«Disallow» se utiliza para indicar que no deseas que los motores de búsqueda rastreen archivos o directorios específicos, mientras que «Allow» permite que los motores de búsqueda accedan a ciertos archivos o directorios incluso si se han establecido reglas de «Disallow».

¿Cuál es la función de «Crawl-delay» en el archivo robots.txt?

La directiva «Crawl-delay» permite especificar un retraso entre las solicitudes realizadas por los motores de búsqueda en tu sitio web. Esto puede ayudar a evitar una carga excesiva en tu servidor.

¿Qué es la directiva «Noindex» en el archivo robots.txt?

La directiva «Noindex» es específica de Google y se utiliza para indicar que no deseas que Google indexe una página o archivo en particular, incluso si está permitido rastrearlo según las reglas de «Allow».

Pero si quieres ahorrarte todo, simplemente descarga aquí tu archivo robots.txt básico y súbelo a la raíz de tu hosting: